Sortieralgorithmen: Definition, Verfahren und Effizienz

Sortieralgorithmen verständlich erklärt: Definition, gängige Verfahren, Laufzeit und praktische Tipps zur Effizienzsteigerung – ideal für Einsteiger und Entwickler.

Ein Sortieralgorithmus ist ein Algorithmus, der die Elemente einer Sammlung in eine bestimmte Reihenfolge bringt. Am häufigsten werden Zahlen nach ihrem Wert und Wörter nach ihrer lexikografischen Reihenfolge (wie sie in einem Wörterbuch oder Telefonbuch erscheinen würden) sortiert. Effizientes Sortieren ist auch für andere Dinge wichtig: Es ist einfacher, ein Element in einer sortierten Sammlung zu finden, und auch das Zusammenführen eines neuen Elements kann einfacher sein, wenn die Sammlung sortiert ist.

Bei der Sortierung muss unterschiedlich berücksichtigt werden, dass die Daten in einigen Fällen nur sequentiell, wie auf einem Band, gelesen werden können.

Grundbegriffe

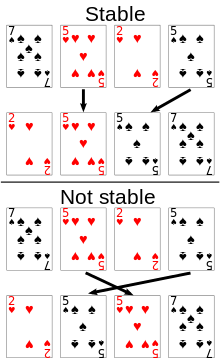

- Stabilität: Ein Sortierverfahren ist stabil, wenn gleichwertige Elemente (z. B. gleiche Schlüssel) ihre relative Reihenfolge beibehalten.

- In-place: Ein Algorithmus arbeitet in-place, wenn er nur einen sehr kleinen, konstanten zusätzlichen Speicherbedarf hat (neben dem Eingabefeld).

- Vergleichsbasiert vs. nicht-vergleichsbasiert: Vergleichsbasierte Algorithmen treffen Entscheidungen durch Vergleiche zwischen Elementen; nicht-vergleichsbasierte Verfahren (z. B. Counting-, Radix- oder Bucket-Sort) nutzen zusätzliche Informationen über die Schlüssel und können für spezielle Datentypen schneller sein.

- Adaptiv: Ein adaptiver Algorithmus nutzt vorhandene Teilordnung (z. B. wenn die Eingabe bereits teilweise sortiert ist) und kann dadurch schneller werden.

- Online vs. Offline: Online-Algorithmen können Elemente verarbeiten, sobald sie ankommen; Offline-Algorithmen benötigen die komplette Eingabe.

Klassische Sortierverfahren (kurze Beschreibung)

- Bubble Sort: Einfach, aber ineffizient (O(n^2) Zeit). Gut zum Lernen, praktisch ungeeignet für große Datenmengen.

- Selection Sort: Wählt wiederholt das kleinste Element und setzt es an die richtige Position. Zeit: O(n^2). Konstanter zusätzlicher Speicher, nicht stabil (ohne Anpassung).

- Insertion Sort: Baut die sortierte Liste schrittweise auf, sehr schnell für kleine oder bereits fast sortierte Arrays. Zeit: O(n^2) im Worst‑Case, O(n) im besten Fall (bereits sortiert).

- Merge Sort: Teilt die Daten rekursiv und führt sortierte Teillisten zusammen. Zeit: O(n log n) sowohl im Durchschnitt als auch im Worst‑Case. Stabil, aber benötigt zusätzlichen Speicher (O(n)). Gut für externe Sortierung und stabile Sortierung.

- Quick Sort: Teilt anhand eines Pivots. Sehr effizient im Durchschnitt (O(n log n)), aber Worst‑Case O(n^2) – lässt sich durch zufällige Pivotwahl oder Introsort absichern. In‑place (mit rekursivem Stack), in der Grundform nicht stabil.

- Heap Sort: Baut einen Heap und entnimmt nacheinander das größte/kleinste Element. Zeit: O(n log n) im Worst‑Case, in-place, aber nicht stabil.

- Counting Sort: Nicht-vergleichsbasiert, linear in der Zeit O(n + k) für Schlüssel in einem beschränkten Bereich k. Stabil, benötigt allerdings zusätzlichen Speicher proportional zu k.

- Radix Sort: Nutzt mehrere Durchläufe von stabilen Zählverfahren (z. B. Counting Sort) für Ziffern / Stellen. Für feste Schlüsselbreite oft O(n). Sehr effizient für Ganzzahlen oder feste Schlüsselgrößen.

- Bucket Sort: Teilt Werte in Bereiche (Buckets) und sortiert diese ggf. separat. Je nach Verteilung kann die erwartete Laufzeit O(n) betragen.

- Timsort: Ein hybrider, stabiler Algorithmus (Kombination aus Insertion und Merge), optimiert für reale Daten (z. B. in Python und Java). Sehr gute praktische Leistung bei teil-sortierten Daten.

- Introsort: Hybrid aus Quick Sort, Heap Sort und Insertion Sort: beginnt mit Quick Sort und wechselt bei schlechtem Verhalten zu Heap Sort. So werden Worst‑Case-Garantien erreicht.

Effizienz und theoretische Grenzen

- Für vergleichsbasierte Sortierverfahren gilt eine untere Schranke von Ω(n log n) für die Anzahl der Vergleiche im Worst‑Case; das bedeutet, kein vergleichsbasierter Algorithmus kann asymptotisch besser als O(n log n) sein.

- Nicht-vergleichsbasierte Verfahren (z. B. Counting, Radix) können unter geeigneten Voraussetzungen in linearer Zeit O(n) laufen, benötigen aber oft zusätzliche Annahmen (beschränkter Schlüsselbereich, feste Schlüsselgröße).

- Speicherkomplexität ist ein wichtiges Kriterium: Merge Sort benötigt O(n) zusätzlichen Speicher, Quick Sort arbeitet in-place mit zusätzlichem Stack (typisch O(log n) durchschnittlich), Counting Sort braucht O(k) zusätzlich.

- Praktische Performance hängt nicht nur von der asymptotischen Laufzeit ab, sondern auch von Faktoren wie Cache-Effizienz, Branch-Prediction, Konstanzfaktoren und Datenverteilung.

Eigenschaften und Auswahlkriterien

- Datenmenge: Für sehr kleine Arrays ist Insertion Sort oft die beste Wahl.

- Stabilität benötigt? Wenn ja, sind Merge Sort, Timsort oder stabil implementierte Varianten zu bevorzugen.

- Speicherbeschränkungen: Wenn wenig zusätzlicher Speicher zur Verfügung steht, eignen sich in‑place-Algorithmen wie Quick Sort oder Heap Sort.

- Wertebereich bekannt/klein? Dann können Counting oder Radix Sort sehr schnell sein.

- Teilweise sortierte Eingaben: Adaptive Algorithmen wie Insertion Sort oder Timsort nutzen das und sind schneller.

Externe Sortierung und sequentielle Medien

Bei sehr großen Datenmengen, die nicht in den Hauptspeicher passen, spricht man von externer Sortierung. Typische Verfahren sind k-Wege-Merge-Verfahren kombiniert mit einer Vorverarbeitung durch Runs (z. B. Sortieren von Blöcken im Speicher und Schreiben als sortierte Runs auf Platte), anschließend mehrstufiges Zusammenführen (k-way Merge). Für sequentielle Medien (z. B. Magnetband) müssen Algorithmen so gestaltet sein, dass wenige und lange sequentielle Lese-/Schreibvorgänge stattfinden. Merge-basierte Verfahren sind hier besonders geeignet, weil sie sich gut an sequentielle Zugriffe anpassen lassen.

Praktische Implementierungen und Bibliotheken

- In vielen Standardbibliotheken werden hybride Algorithmen eingesetzt: z. B. verwendet C++ std::sort in vielen Implementierungen Introsort, Python und moderne Java-Implementierungen nutzen Timsort für Listen.

- Parallelisierung: Für sehr große Datenmengen oder auf Mehrkernsystemen können parallele Sortieralgorithmen (parallel quicksort, parallel mergesort, MapReduce‑basierte Ansätze) erhebliche Geschwindigkeitsgewinne bringen.

Empfehlungen kurz zusammengefasst

- Für kleine Arrays: Insertion Sort (oder die in Standardbibliotheken verwendete Kombination).

- Für allgemeine In‑Memory-Sortierung großer Arrays: Quick Sort (mit Schutzmechanismen wie Introsort) oder Timsort für stabile Sortierung und reale Daten.

- Für stabile, vorhersehbare Laufzeit oder externe Sortierung: Merge Sort bzw. k-way Merge.

- Für Schlüssel in begrenztem Bereich: Counting oder Radix Sort.

Sortieralgorithmen sind ein zentrales Thema der Informatik mit vielen Varianten und praktischen Optimierungen. Die Wahl des geeigneten Verfahrens hängt von Datencharakteristika, Speicher- und Leistungsanforderungen sowie von Stabilitäts- und Online-/Offline-Anforderungen ab.

Ein Beispiel für eine stabile Sortierung auf Spielkarten. Wenn die Karten mit einer stabilen Sortierung nach Rang sortiert werden, müssen die beiden 5er in der sortierten Ausgabe in der gleichen Reihenfolge bleiben, in der sie sich ursprünglich befanden. Wenn sie mit einer nicht stabilen Sortierung sortiert werden, können die 5er in der sortierten Ausgabe in der umgekehrten Reihenfolge enden.

Suche in der Enzyklopädie